OpenAI confirma que no tiene suficientes GPUs para dar servicio completo a ChatGPT-4.5

La escasez de procesadores gráficos provoca largas esperas y funcionamiento irregular en el servicio estrella de OpenAI. Sam Altman admite que la compañía no puede satisfacer la creciente demanda de su modelo más avanzado

Los usuarios de ChatGPT experimentan tiempos de espera cada vez más largos mientras la compañía lucha contra una grave escasez de hardware. La situación llega en pleno despliegue de su versión 4.5, un modelo que requiere una capacidad de procesamiento muy superior a sus predecesores y que ha saturado los centros de datos de la empresa en cuestión de semanas.

"No tenemos suficiente capacidad computacional", ha reconocido Sam Altman en X, confirmando lo que miles de usuarios ya experimentaban en forma de respuestas lentas y funcionamiento irregular. El CEO de OpenAI ha añadido que están "trabajando para ampliar nuestra infraestructura lo más rápido posible", aunque sin proporcionar plazos concretos para la resolución del problema.

La escasez de chips frena la expansión de la IA

GPT-4.5 is ready!

— Sam Altman (@sama) February 27, 2025

good news: it is the first model that feels like talking to a thoughtful person to me. i have had several moments where i've sat back in my chair and been astonished at getting actually good advice from an AI.

bad news: it is a giant, expensive model. we…

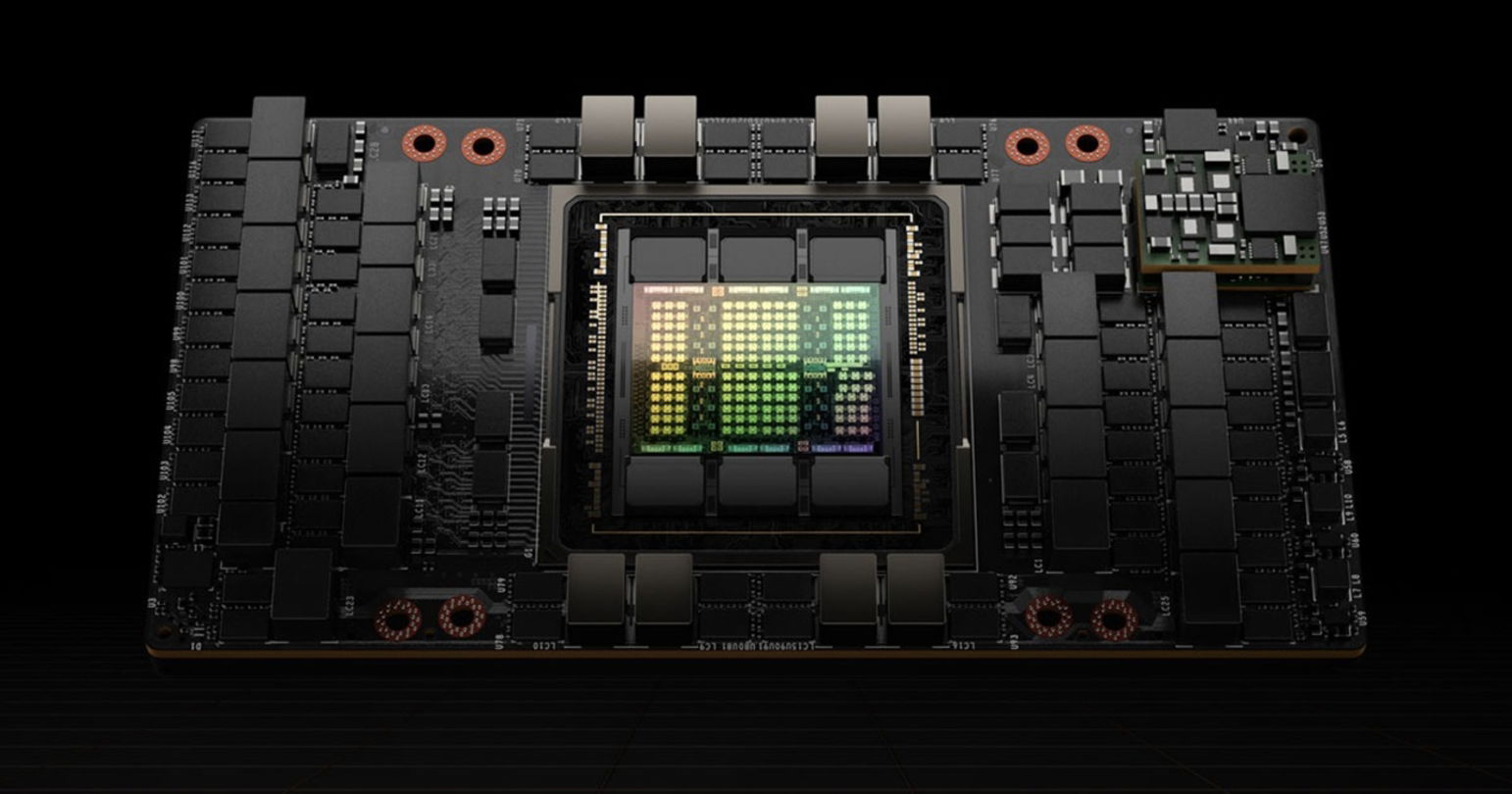

La situación de OpenAI no es un caso aislado. NVIDIA, principal fabricante de las GPUs especializadas que utilizan estos sistemas, mantiene listas de espera de hasta 9 meses para sus chips H100, esenciales para el entrenamiento e inferencia de modelos avanzados. Cada servidor para ChatGPT-4.5 necesita entre 4 y 8 de estas unidades, con un coste aproximado de 25.000 dólares por chip.

Esta crisis de suministro afecta especialmente a ChatGPT-4.5, cuyas mejoras en razonamiento y programación exigen un 60% más de potencia computacional que la versión anterior. Los análisis técnicos indican que el modelo procesa hasta 300.000 tokens por minuto durante operaciones complejas, saturando incluso la infraestructura de Microsoft Azure reservada para OpenAI.

La escasez ha provocado que competidores como Anthropic con Claude y Google con Gemini ganen terreno, al contar estos últimos con infraestructura propia más consolidada o, en el caso de Google, con sus propios chips TPU desarrollados internamente.

El problema se complica cuando observamos que ChatGPT-5 ya tiene fecha de lanzamiento prevista y requerirá aún más capacidad de procesamiento. Las estimaciones del sector apuntan a que el nuevo modelo necesitará el doble de potencia que su predecesor, lo que plantea serias dudas sobre la viabilidad de su despliegue en las condiciones actuales del mercado.

Impacto directo en los usuarios y estrategia empresarial

Chip H100 de NVIDIA

OpenAI ha implementado un sistema de priorización que favorece claramente a los suscriptores de pago. Los datos internos filtrados a Bloomberg indican que los usuarios gratuitos experimentan tiempos de espera hasta cinco veces superiores a los de hace tres meses, mientras que las funciones avanzadas como el análisis de código quedan frecuentemente restringidas durante horas punta.

Esta situación contrasta con las declaraciones de Altman sobre ChatGPT-4.5, donde prometía un acceso más democrático a capacidades "transformadoras". Los desarrolladores independientes han expresado su frustración en foros técnicos, señalando que la limitación actual impide utilizar el modelo para aplicaciones comerciales consistentes.

Microsoft, principal inversor de OpenAI, ha destinado 3.500 millones de dólares adicionales para ampliar centros de datos específicamente orientados a IA generativa. Sin embargo, las fuentes del sector indican que incluso con esta inversión, resolver completamente el problema podría llevar entre 6 y 12 meses debido a los cuellos de botella en la cadena de suministro de semiconductores.

La crisis de hardware también está obligando a OpenAI a replantearse su estrategia de integración entre GPT-4.5 y GPT-5, según ha confirmado un portavoz de la compañía. La opción más probable es que prioricen optimizar el rendimiento del modelo actual antes de destinar recursos al desarrollo de su sucesor.

Los analistas de Morgan Stanley estiman que esta situación podría costar a OpenAI entre 200 y 300 millones de dólares en ingresos no percibidos durante 2024, una cifra significativa para una empresa que aún busca su modelo de negocio definitivo en un mercado cada vez más competitivo.

Puedes seguir a Andro4all en Facebook, WhatsApp, Twitter (X) o consultar nuestro canal de Telegram para estar al día con las últimas noticias de tecnología.